Hay historias muy curiosas en el mundo de la tecnología. Una de ellas es la del origen del término bug (error informático, en español). El episodio remite a la posguerra mundial e implica a un ordenador del tamaño de una cancha de baloncesto y una mariposa nocturna despistada.

Hace justo tres cuartos de siglo se utilizó por primera vez el término bug para dar cuenta de un error en una computadora. Fue, en concreto, el 9 de septiembre de 1947. Aquel día, el equipo científico de la Universidad de Harvard, en Cambridge (Massachusetts, Estados Unidos), descubrió que el superordenador Mark II, desplegado en sus instalaciones, daba errores constantes.

Este computador era, en realidad, una calculadora gigantesca (25 toneladas de hierro y cables que ocupaban 370 metros cuadrados). Aunque solo era capaz de realizar algunas de las operaciones que hoy se le exigen a las calculadoras científicas que lleva en la mochila cualquier estudiante de secundaria.

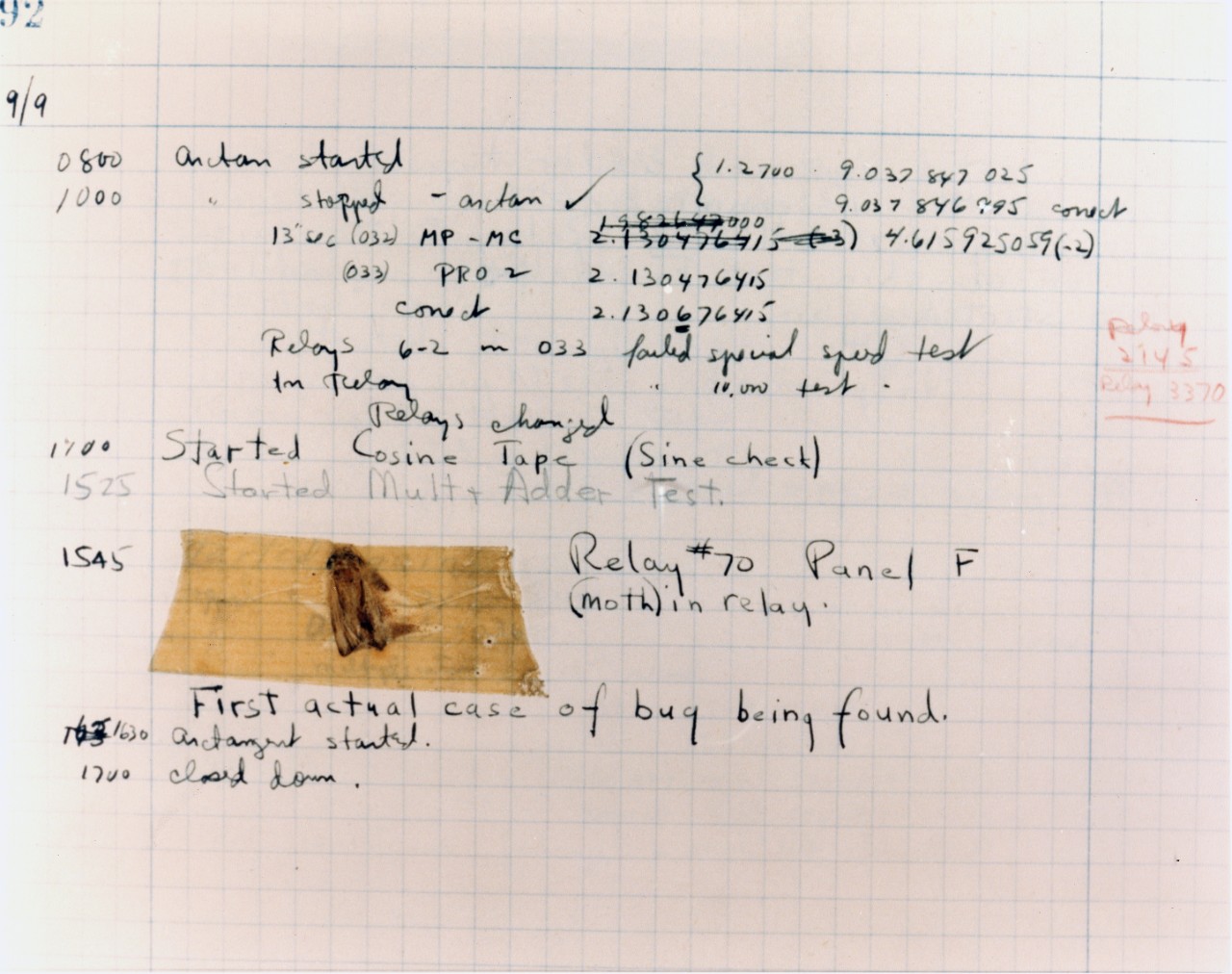

Aquel día de finales de verano de 1947, alguien del equipo de la prestigiosa universidad de la costa este escribió una nota en el registro de uso del Mark II. Allí puso que a las 15:45 horas había sido “encontrado el primer caso real de bug”. “First actual case of bug being found”, rezaba la hoja de registro, que hoy se conserva en el Museo Nacional de Historia Americana de la Institución Smithsonian, en Washington (Estados Unidos). Para más señas, el insecto estaba aprisionado en el circuito del relé 70 del Panel F.

Además, para dejar la mejor constancia de lo que había pasado, el registrador del suceso no tuvo otra ocurrencia que pegar con una cinta adhesiva el cadáver de la polilla en el registro del Mark II. Un armatoste que había sido encargado nada menos que por la Marina de los Estados Unidos.

Desde ese momento, bug no solo significó insecto o bicho, sino que también empezó a ser la palabra usada por la comunidad tecnológica para referirse a esos errores que dejan en azul una pantalla o hacen que un programa informático entre en bucle.

Grace Hopper también estuvo allí

La historia no se queda ahí, sino que también tiene a una ilustre protagonista. En el grupo que mantenía el Mark II estaba la legendaria Grace Hopper, matemática y militar de la Armada estadounidense y pionera de la programación unos años después.

Y es que formó parte del grupo de informáticos que a finales de los cincuenta, hartos del programa en ensamblador de los grandes ordenadores de la época, creó el lenguaje de programación COBOL. Fue un paso clave, porque hoy en día este lenguaje sigue gobernando los sistemas de muchos bancos e instituciones financieras. Y está detrás de las operaciones de los cajeros automáticos, la gestión de los seguros y el cálculo de las pensiones.

Pues bien, Hopper confesó que la polilla había entrado en la sala del Mark II por una ventana que había dejado abierta un miembro del turno de noche. Sin duda, atraída por las luces de la máquina y de la gigantesca instalación.

Edison también habló de bugs antes que nadie

En cualquier caso, no fueron los científicos de Harvard los primeros que hablaron de bug para referirse al error de una máquina. En 1878, el también legendario Thomas Alva Edison, el estadounidense que mejoró y popularizó la bombilla incandescente y que inventó el fonógrafo, dejó también constancia en una carta de que uno de sus teléfonos tenía problemas de funcionamiento debido a un bug. Edison aseguraba que el insecto había encontrado “buenas condiciones” para vivir en el aparato.

Más tarde, en 1889, el propio Edison volvió a hablar de otro bug, que en este caso causaba interferencias en un fonógrafo. No eran bugs informáticos los que quitaban el sueño al famoso inventor y empresario, pero sí sentaron el precedente para la polilla del Mark II.

El efecto 2000: el bug informático más famoso

La polilla de Harvard fue el primer bug de la historia de la informática, pero no ha sido el más popular. En 1999, el mundo tecnológico tembló por el llamado ‘efecto 2000’. Hasta ese momento, los desarrolladores habían optado por escribir el año en las fechas de cualquier tipo de archivo o registro con los dos últimos dígitos. La razón es que, omitiendo los dígitos de la centuria, ahorraban memoria y espacio de almacenamiento. Sin embargo, esa decisión hizo temer a muchos que, en el primer día del siglo XXI, los sistemas en realidad se pasaran al 1 de enero de 1900, en lugar de 2000.

Y eso desató el temor a que sistemas de todo tipo se descontrolaran. Algunos pintaron un escenario catastrófico: aviones que caerían sin razón aparente, sistemas bancarios que colapsarían e infraestructuras públicas que dejarían de funcionar por el despropósito de la fecha. Sin embargo, casi nada pasó. Los incidentes del llamado ‘efecto 2000’ fueron leves. En España, por ejemplo, se detectaron problemas menores en dos centrales nucleares, en alguna gasolinera y en el sistema de recogida de datos de tráfico.

Bien es verdad que en los años previos, las empresas y los gobiernos de todo el mundo gastaron cerca de 214 000 millones de dólares (unos 217 000 millones de euros) en actualizar sus sistemas informáticos para evitar la catástrofe que nunca llegó.

Por Juan I. Cabrera

Imágenes | Naval History and Heritage Command, Lynn Gilbert (Wikimedia Commons), Wikimedia Commons/ThomasAlvaEdison/Wellcome Images