En 2013, la agencia tributaria de los Países Bajos tuvo una idea. ¿Por qué no diseñar un sistema de inteligencia artificial (IA) que ayudase a detectar posibles casos de fraude fiscal?

Poco a poco, las sospechas se convirtieron en multas. Miles de familias neerlandesas empezaron a recibir notificaciones y sanciones por delitos que no habían cometido. El algoritmo los había señalado y nadie en la autoridad fiscal pensó que podía estar equivocándose, que el resultado podría estar sesgado. Tras varios años de litigio, quedó demostrado que la agencia tributaria había violado leyes de privacidad al instalar este sistema. Y que la IA desarrollada no era inclusiva ni atendía a los principios de igualdad.

Por el camino, claro, el algoritmo arruinó la vida de miles de personas. Las investigaciones que llegaron más tarde demostraron que el sistema de aprendizaje automático tomaba decisiones a partir de una serie de factores de riesgo que habían sido decididos por la autoridad fiscal del país. Entre otros, estaban el tener doble nacionalidad, ser extranjero y pertenecer a una familia de bajos ingresos. Es decir, sesgos. ¿Podrían haberse evitado?

Guía para una IA inclusiva

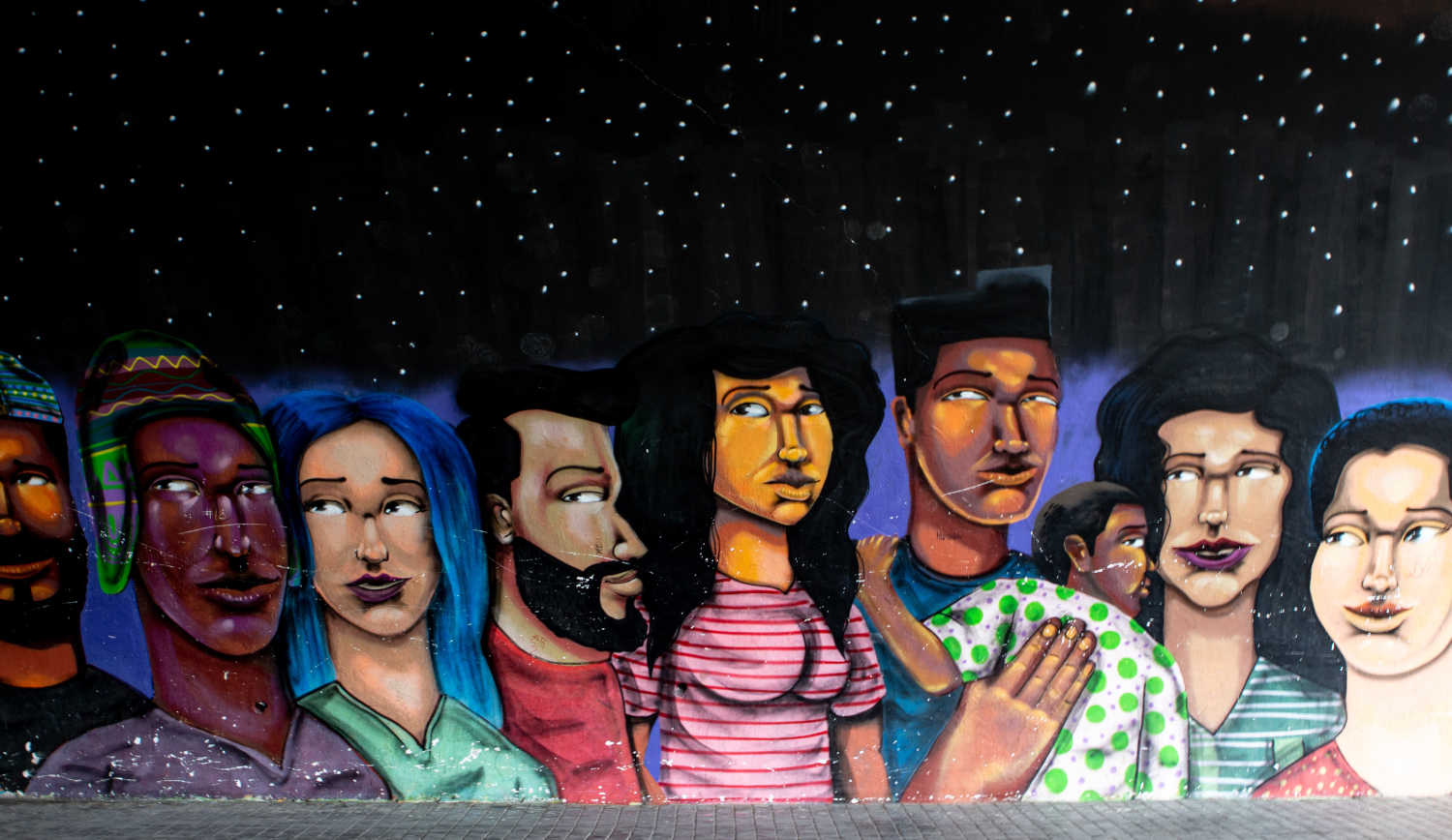

El caso neerlandés no es único. Según el Global Future Council on Artificial Intelligence for Humanity, del Foro Económico Mundial (FEM), la falta de inclusividad en el desarrollo y en la gobernanza de la IA ha generado perjuicios a empresas (tanto daños financieros como de reputación) y a múltiples grupos y comunidades. Como minorías étnicas, culturales, lingüísticas e ideológicas. Para intentar evitarlo, el FEM ha publicado su guía para la igualdad y la inclusión en el desarrollo y la gobernanza de la IA.

El documento, ‘A Blueprint for Equity and Inclusion in AI’, identifica siete pasos fundamentales en el ciclo de vida de estos sistemas y señala una serie de buenas prácticas, tanto desde el punto de vista de la gobernanza como el de desarrollo. En muchos casos, ambos enfoques se superponen.

1. Identificación del caso de uso o el problema

A la hora de identificar el caso de uso o el problema que puede ser resuelto con IA, el ecosistema de gobernanza debe, entre otras cosas, definir el tema desde diferentes puntos de vista y asegurar que el equipo de desarrolladores que va a enfrentarse al problema es lo más diverso posible. Por su parte, el ecosistema de desarrollo debe hacer un análisis de mercado amplio y asegurarse de que el modelo de IA va a recibir inputs de todos los grupos sociales y étnicos. Habrá que prestar especial atención a aquellos que suelen estar infrarrepresentados.

2. Diseño del modelo

El desarrollo del modelo debe empezar con una reflexión profunda alrededor de las siguientes preguntas: por qué y para quién es necesario. Tanto desde la gobernanza como desde el desarrollo deben identificarse las necesidades de los datos que van a alimentar el modelo de IA. Y tenerse en cuenta las opiniones y los puntos de vista de todos los grupos interesados y afectados por el producto final.

3. Recolección de los datos

En esta tercera fase, es necesario identificar rutas para una recopilación de datos más inclusiva, con un marco de gobernanza sólido y diseñada desde el respeto a la privacidad. Para ello, se debe asegurar que las bases de datos utilizadas son inclusivas y representan de forma equitativa a todos los grupos demográficos.

4. Desarrollo del modelo y fase de pruebas

Aunque sean dos pasos diferentes, las fases de desarrollo y testeo se retroalimentan de forma continua. Así, las buenas prácticas definidas en la guía del FEM pueden ser llevadas a cabo en ambos procesos.

Desde el punto de vista de la gobernanza, es necesario establecer varias rondas de desarrollo y testeo con diferentes enfoques, monitorizar el impacto de la IA en diferentes comunidades y determinar las métricas inclusivas bajo las cuales se medirá el éxito y el fracaso del producto.

En cuanto al equipo de desarrollo, este debe tener en cuenta una serie de principios éticos, de transparencia y de respeto a la privacidad. Además, los testeos se harán de forma controlada, en grupos de prueba que representen a todas las comunidades sociales y étnicos.

5. Despliegue y monitorización

Al igual que en el caso anterior, ambas fases están relacionadas de forma estrecha. Una vez desarrollada la IA, su despliegue comercial debe ser acompañado de una monitorización muy cercana para identificar posibles impactos negativos inesperados. Deben ponerse en práctica sistemas de rendición de cuentas efectivos, así como herramientas para detectar la aparición de consecuencias perjudiciales o de nuevos grupos afectados que no habían sido tenidos en cuenta en un principio.

“Habitualmente, la inclusión llega tarde a los procesos de diseño e implementación de nuevas capacidades digitales. ¿El resultado? El trabajo es dirigido por un grupo pequeño y privilegiado y el resto queda al margen de los beneficios. Esta guía proporciona herramientas para contrarrestar estas tendencias en el campo de la IA. Si se actúa en consecuencia, podríamos encaminarnos hacia una sociedad más inclusiva en general”, concluyó Nadjia Yousif, directora general y socia de Boston Consulting Group, uno de los grupos participantes en el informe del FEM.

Por Juan F. Samaniego

Imágenes | Unsplash/Miles Peacock, Possessed Photography, Mark Stosberg