Un coche autónomo toma la decisión de salvar a sus ocupantes a costa de no evitar el atropello de un grupo de niños. ¿O debería haber sido al revés? Más allá de los dilemas éticos clásicos que rodean las decisiones de una inteligencia artificial autónoma, existen multitud de retos a la hora de evaluar los algoritmos.

Desde el punto de vista ético, la inteligencia artificial (IA) tiene muchos desafíos que resolver. Si buscamos una imagen genérica de líderes mundiales en Google, ¿el resultado serán hombres, mujeres o un grupo mixto? Si dejamos que una IA resuelva un juicio sencillo, ¿mostrará algún tipo de sesgo hacia los grupos que reflejan, estadísticamente, mayores tasas de criminalidad? ¿O será capaz de mostrar empatía y analizar las zonas grises de cada situación concreta?

La ética y la inteligencia artificial

“La inteligencia artificial (IA) y la robótica son tecnologías que tendrán un impacto significativo en el desarrollo de la humanidad en un futuro cercano. Han planteado dudas fundamentales sobre qué deberíamos hacer con estos sistemas, qué deberían hacer los propios sistemas, qué riesgos implican y cómo podemos controlarlos”, explica Vincent Müller, de la Universidad de Standford, en el artículo ‘Ethics of Artificial Intelligence and Robotics’.

Asumiendo que las tecnologías siempre van a tener impactos positivos y negativos, el autor hace hincapié en la necesidad de fomentar no solo un uso responsable de la IA, sino un diseño también responsable. Partiendo de esta base, Müller señala los principales debates éticos que, hoy por hoy, rodean el uso de la inteligencia artificial:

- La vigilancia y la seguridad. Definir los límites de la privacidad, quién, cómo y con qué objetivos se toman datos, quiénes son responsables de estas acciones o proteger el derecho a la intimidad de las personas son algunas de las cuestiones a definir.

- La manipulación del comportamiento. En este sentido, existe un importante debate abierto alrededor del uso de las tecnologías de IA para crear vídeos e imágenes falsas (deep fake) para lograr manipular al público.

- Los sesgos en la toma de decisiones. Desde pequeñas decisiones como los resultados de una búsqueda en internet o las recomendaciones de YouTube hasta sistemas que asisten asuntos policiales, judiciales o médicos, la IA está cada vez más presente en la toma de decisiones. Asegurar que los algoritmos son entrenados sin ningún tipo de sesgo es clave.

- La opacidad de los sistemas. La mayoría de algoritmos y sistemas de IA son secretos. Los usuarios reciben sus resultados, pero no saben cómo se han producido. Una mayor transparencia puede contribuir a evitar sesgos en los patrones de comportamiento de las inteligencias artificiales.

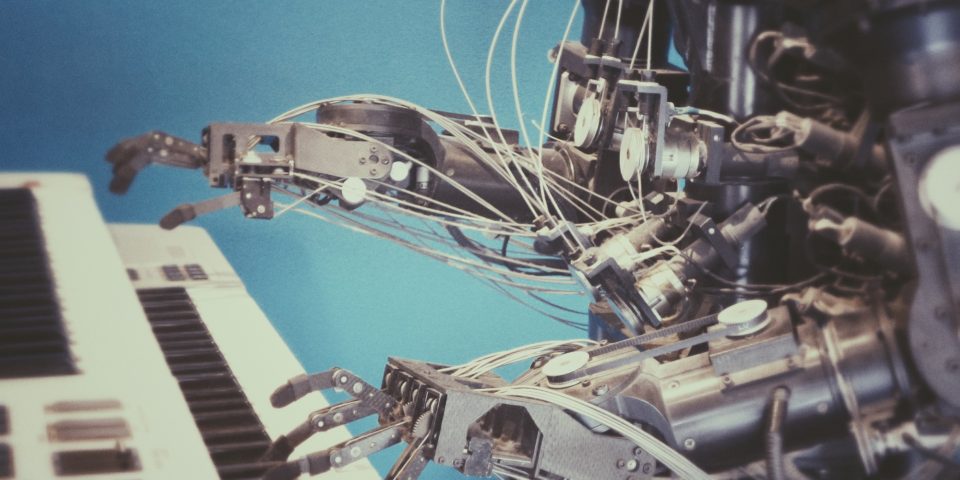

- La interacción entre humanos y máquinas. ¿Cómo asegurar que trabajar con robot vaya a ser seguro? ¿Cómo lograr que un robot humanoide no se utilice para engañar? ¿O cómo lograr que una IA no sea usada para fomentar una relación de dependencia emocional entre máquina y humano? Este campo acumula cada vez más interrogantes.

- El empleo y la automatización. La tecnología permite hoy que cada vez más tareas sean llevadas a cabo por máquinas, de forma automática. Como consecuencia, la IA va a destruir muchos empleos humanos en el futuro, al tiempo que creará otros nuevos. Un campo importante de la ética estudia cómo lograr que esta transición no desequilibre nuestras sociedades.

- La autonomía de la IA. Al igual que con el ejemplo del coche que abría este artículo, existen muchas cuestiones por definir en el futuro de las máquinas autónomas. ¿Qué decisiones queremos que tomen? ¿Quién va a ser responsable de ellas? ¿Habrá siempre alguien en control?

- La ética de las máquinas. Siguiendo las líneas marcadas por Isaac Asimov con sus tres leyes de la robótica, un campo importante de la ética estudia cómo tratar las máquinas como sujetos y no como objetos, entidades limitadas por sus propios principios éticos y morales.

- Y qué pasa con la singularidad. La mayor parte de estas cuestiones perderán buena parte de su sentido cuando las máquinas alcancen la llamada singularidad. Es decir, cuando alcancen el nivel de inteligencia suficiente como para construir por sí mismas otras máquinas más inteligentes. Cuando superen al ser humano y escapen definitivamente a su control.

Los retos de evaluar y auditar un algoritmo

Volviendo al día a día del desarrollo de la inteligencia artificial, los ingenieros detrás de los algoritmos se enfrentan a múltiples retos a la hora de auditar una IA. Por un lado, están los aspectos técnicos, más fácilmente evaluables. Por otro, están todos los aspectos éticos, los impactos de la tecnología en los individuos y en la sociedad.

Con la intención de desarrollar un método de control de los algoritmos desde el principio, los investigadores de Google AI y Partnership on AI han propuesto un sistema de auditorías internas. En el artículo ’Closing the AI Accountability Gap’, sostienen que es necesario desarrollar procedimientos internos para controlar el desarrollo de la IA.

Las empresas suelen ser reacias a divulgar todos sus datos para que sean evaluados externamente. Sin embargo, un sistema interno, estandarizado y transparente puede reforzar el control, mejorando la capacidad de corregir los algoritmos desde el inicio de su desarrollo y no reaccionando a los problemas éticos a posteriori.

SMACTR: la propuesta de Google

El método de auditoría interna propuesto por Google AI y la Partnership on AI no es muy diferente a los utilizados en otras industrias. Se estructura en una serie de documentos denominados artefactos; y se divide en cinco pasos, que se resumen en las siglas SMACTR, del inglés objetivos, mapeo, recolección de artefactos, pruebas y reflexión.

- Objetivos o scoping. En esta primera fase, se examinan las motivaciones y el impacto del sistema que quiere crearse. Así, se fija un objetivo bajo un punto de vista ético, buscando eliminar sesgos de base en la programación y limitar los impactos sociales.

- Mapeo. La segunda fase analiza el ciclo de desarrollo del producto y las implicaciones en los diferentes colaboradores y proveedores. Aquí también se analiza cómo se toman las decisiones en el proceso y cómo estas impactarán en el resultado final.

- Recolección de artefactos o collection. Los encargados de la auditoría revisan los artefactos, los documentos producidos durante las dos primeras fases. Estos deben elaborarse bajo una serie de criterios estandarizados.

- Pruebas o testing. Durante la cuarta fase, con el producto ya desarrollado, los auditores interactúan con la IA para comprobar si el sistema cumple con los principios éticos de la organización. En este paso también se incluye un análisis de posibles riesgos éticos, intentando anticipar qué puede salir mal.

- Reflexión. En la última fase, los resultados de la auditoría deben confrontarse con las expectativas iniciales. Ante cualquier desviación desde el punto de vista ético, los auditores propondrán planes para corregirla y mitigar los riesgos.

Tal como reconocen los propios autores de este marco de trabajo, las auditorías internas nunca son independientes. Los auditores deben ser conscientes de sus propios sesgos y de la importancia de su trabajo para la organización. Además, deben contar con el apoyo de los líderes de la compañía. Si una auditoría ética recomienda paralizar el desarrollo de una IA, la decisión no debe cuestionarse.

Por Juan F. Samaniego

Imágenes | Unsplash/Brett Jordan, Possessed Photography, Fitore F.